Samstag, 2. März 2024 von Dr. Michael Gebert

Samstag, 2. März 2024 von Dr. Michael Gebert

Pragmatischer Umgang mit Datenschutz bei KI-Systemen

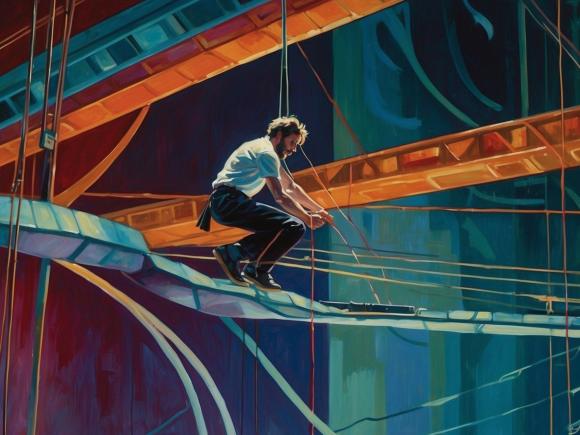

KI und Datensicherheit - Ein Drahtseilakt

Die jüngsten Fortschritte bei großen Sprachmodellen wie GPT-3 haben zu einem regelrechten Hype um Künstliche Intelligenz geführt. Viele Unternehmen und Privatpersonen experimentieren nun damit, diese Modelle für verschiedene Anwendungsfälle einzusetzen. Doch mit dem vermehrten Einsatz von KI sind auch viele Fragen zur Datensicherheit und Privatsphäre aufgekommen. Dieser Artikel soll einen grundsätzlichen Überblick über die wichtigsten Datenschutzaspekte bei der Nutzung von KI-Systemen geben. Fragen dazu gibt es mannigfaltig und praktische Handlungsempfehlungen, wie Unternehmen und Privatpersonen ihre Daten bestmöglich schützen können sind im Umgang mit KI noch rar gesät.

Große Tech-Unternehmen wie Google, Amazon und Meta haben seit Jahren Zugang zu unseren persönlichen und geschäftlichen Daten. Bislang wurde dieser Datenbestand hauptsächlich für zielgerichtete Werbung genutzt. Mit dem Aufkommen von KI hat sich dies grundlegend geändert. KI-Systeme wie ChatGPT werden immer "schlauer", je mehr Informationen sie konsumieren. Daher besteht nun ein viel größeres Interesse dieser Unternehmen, möglichst viele Daten zu sammeln und in die Entwicklung der KI einfließen zu lassen. Dies wirft viele Fragen zum Datenschutz auf. In der Theorie gelten für KI-Anbieter die gleichen Datenschutzvorschriften wie für andere Unternehmen. In der EU gibt es mit der DSGVO strenge Regeln zum Schutz persönlicher Daten. In der Praxis ist eine lückenlose Kontrolle der Trainingsdaten von KI-Systemen jedoch so gut wie unmöglich. Selbst wenn bestimmte Daten nicht aktiv eingespeist werden, können sie über Umwege in die Trainingssets gelangen. Daher bleibt momentan nur, den KI-Anbietern zu vertrauen, dass sie die selbstgesetzten Richtlinien einhalten. Viele Unternehmen haben diesbezüglich jedoch Zweifel und investieren in den Aufbau privater KI-Systeme, um die Kontrolle über sensible Daten zu behalten.

Wie wirksam sind Datenschutz-Einstellungen bei KI-Systemen?

Innerhalb des OpenAI-Ökosystems gibt es einige Möglichkeiten, den Zugriff auf eigene Inhalte einzuschränken:

Bei Nutzung der OpenAI-APIs über die Plattform verspricht das Unternehmen, eingegebene Inhalte nicht zum Training zukünftiger GPT-Versionen zu verwenden. Hier gibt es also datenschutzrechtliche Garantien.

Auch ChatGPT für Teams soll keine Kunden-Inhalte für Trainingszwecke nutzen. Die Verbraucherversionen von ChatGPT unterliegen jedoch nicht diesen Einschränkungen.

Über das OpenAI-Nutzerkonto lässt sich die Option "Nicht für Training verwenden" aktivieren. Dies betrifft dann zukünftige ChatGPT-Eingaben. Für bereits erfolgte Eingaben gilt dies nicht rückwirkend. Auch andere KI-Anbieter wie Google bieten für Geschäftskunden mittlerweile derartige Privatsphäre-Einstellungen an. Als Privatperson oder kleines Unternehmen sollte man unbedingt diese datenschutzfreundlichen Optionen nutzen. In der Praxis gibt es jedoch Einschränkungen, wie wirksam derartige Garantien tatsächlich sind.

Auch wenn ich alle verfügbaren Privatsphäre-Einstellungen bei meinen Accounts aktiviert habe, bin ich skeptisch, ob KI-Systeme tatsächlich auf genehmigte Inhalte beschränkt werden können. Mit der rasanten Weiterentwicklung und Verbreitung von KI wird es fast unmöglich, den gesamten Wissensstand dieser Systeme nachzuvollziehen und auf korrekte Einhaltung der Nutzungsrechte zu überprüfen. Selbst wenn Inhalte unmöglich aus einer KI entfernt werden können, ist eine Bestimmung der Herkunft undogmatisch. Dies zeigt auch die Klage der New York Times gegen OpenAI. Kurz gesagt: Die KI-Konzerne können Versprechen abgeben, aber niemand kann überprüfen, was tatsächlich im Hintergrund passiert. Externe Datenschutz-Initiativen wie die DSGVO haben ähnliche Durchsetzungsprobleme. Ohne Einblick in die real genutzten Trainingsdaten bleiben Regeln letztendlich wirkungslos.

Ein möglicher ausgewogene Ansatz: Daten-Kategorisierung

Es bleibt also nur, den KI-Anbietern zu vertrauen - und dieses Vertrauen wurde schon mehrfach enttäuscht. Daher empfehle ich folgenden ausgewogenen Ansatz beim Umgang mit sensiblen Daten.

Eine Kategorisierung der eigenen Daten und Inhalte ist nötig und sinnvoll:

Daten, die öffentlich verfügbar sind oder öffentlich gemacht werden sollen, können bedenkenlos in KI-Systemen wie ChatGPT genutzt werden. Sie gelangen ohnehin früher oder später über andere Wege in die Trainingssets.

Daten, die geheim bzw. geschäftskritisch sind, sollten derzeit nicht in Cloud-basierten KI-Systemen verwendet werden. Trotz Privatsphäre-Einstellungen ist ein Datenschutzrisiko nicht auszuschließen.

Bei allen anderen Daten reichen Basis-Privatsphäremaßnahmen aus. Eine punktuelle Nutzung in KI-Systemen ist akzeptabel. Hier überwiegt der praktische Nutzen den theoretischen Verlust der Datensicherheit.

Warum KI auch unsere Daten zum überleben braucht

Es gibt gute Gründe, sich mit dem Datenschutz bei KI-Systemen auseinanderzusetzen. Die Optionen zur Kontrolle der eigenen Daten sind jedoch begrenzt. In den meisten Fällen überwiegt der praktische Nutzen von KI die abstrakte Gefahr des Kontrollverlusts. Die Kern-Empfehlung lautet: Fokussieren Sie Ihre Bemühungen beim Schutz der wertvollsten Daten und vertrauen Sie bei non-kritischen Inhalten auf Basis-Maßnahmen.

Hat Ihnen dieser Beitrag eine pragmatische Entscheidungsgrundlage zum Umgang mit KI und Datenschutz gegeben? Über Kommentare, Anregungen, Erahrungsberichte und Rückfragen freuen wir uns.

#KuenstlicheIntelligenz #MachineLearning #Datenschutz #Datensicherheit #Privatsphaere #ChatGPT #OpenAI #RL #ReinforcementLearning #NLG #NaturalLanguageGeneration #Sprachmodelle #NLP #NaturalLanguageProcessing #ITSicherheit #Informationssicherheit #Datenethik #Datennutzung #Datentransparenz #DataGovernance #Datensouveraenitaet #DSGVO #EUDataRegulation #Datenstrategie #DataStrategy #Datenkompetenz #DataLiteracy #Datennutzungsrechte #Dateneigentum #PrivacyByDesign #PrivacyEngineering #ZeroTrust #DataCentricSecurity #DataClassification